获取优惠价格

Tel:18790282122PSGD液压圆锥破碎机

PSG西蒙斯圆锥破碎机 郑州美卓矿机有限公司

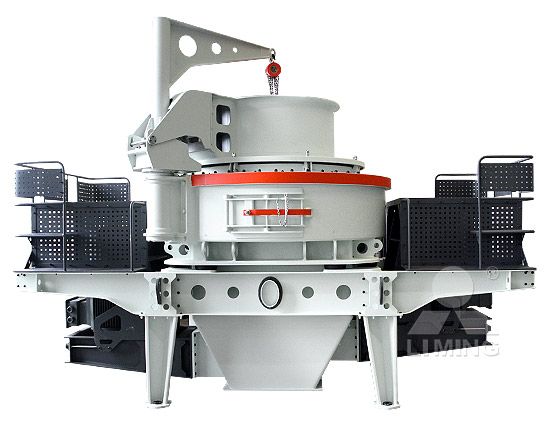

psg系列西蒙斯圆锥破碎机广泛应用在冶金、建材、筑路、化学与硅酸盐等行业中,适用于中等和中等以上硬度的各种矿石和岩石,本机具有破碎比大、效率快、处理量大、运作成 液压圆锥破碎机 外文名 HCC Hydraulic Cone Crusher 简 称 液压圆锥破 性 能 硬物料破碎的最佳选择 分 类 单缸式、多缸式 目录液压圆锥破碎机 百度百科

查看更多

液压型圆锥破碎机好在哪?构造以及作业原理是什么

液压圆锥破碎机的优势: 1、高转速与冲程的完整结合,大大提高了 额定功率 和通过能力,破碎比更大,生产效率更高。 2、所有部件都有 耐磨保护层 ,使零部件的损伤度降到 产品介绍. PSG系列西蒙斯圆锥破碎机广泛应用于冶金工业、建材工业、筑路工业、化学工业与硅酸盐工业中,适用于破碎中等和中等以上硬度的各种矿石和岩石。. 西蒙斯圆锥破碎 中鑫重工西蒙斯圆锥破碎机-矿机之家

查看更多

多缸液压圆锥破碎机 百度百科

多缸液压圆锥破碎机是在 弹簧圆锥破碎机 的基础上发展起来的,它的基本结构与弹簧圆锥破碎机相似。 多缸液压与弹簧圆锥破碎机的区别,只是原来的10-16组弹簧,换成10-16个 PSGD-0906圆锥机是破碎锥大端直径为900mm的西蒙斯(弹簧)圆锥破碎机,破碎腔型为短头中型,出料粒度在3~16mm,适合破碎不大于65mm的物料,每小时产量在27~100吨, PSGD-0906西蒙斯圆锥破碎机-参数-液压-弹簧-中誉鼎力

查看更多

PSGD-2120弹簧圆锥破碎机_PSGD短头特粗型圆锥破_2120圆锥

psgd-2120弹簧圆锥破碎机采用层压的原理破碎物料,擅长破碎花岗岩、玄武岩等硬度较高的物料,出料粒形可调节,适合作为矿山生产项目的细碎整形设备使用,其配置方案还需 PSGD-0605圆锥破碎机设备介绍. PSGD-0605圆锥破型号属于西蒙斯圆锥破碎机中短头型设备,适用于粗碎加工,破碎锥大端直径为600mm,每小时能生产22~70吨石子,配置的 PSGD-0605西蒙斯圆锥破碎机-技术参数-中誉鼎力-新乡市

查看更多

PSG系列圆锥破碎机 搜狗百科

psg系列圆锥破碎机是在传统破碎机基础上研发出来的新型 破碎机,,适用于破碎中等和中等以上硬度的各种矿石和岩石,广泛应用在冶金工业、建材工业、筑路 在20世纪40年代,随着液压技术的发展,促使在圆锥破碎机可以采用液压调整排料口和实现过载保护,这种破碎机称为液压圆锥破碎机。它是美国阿利斯一卡尔默斯(Allis-Chalmers)公司在1948年首先生产的液压圆锥破碎机和液压旋回破碎机。此后经不断地完善和改进,很快在世界多国得到推广使用。液压圆锥破碎机 百度百科

查看更多

深度学习并行训练——AD-PSGD算法-CSDN博客

深度学习并行训练——AD-PSGD算法. VIP文章 xcy6666 于 20:42:33 发布. 阅读量2.7k 收藏 3. 点赞数 2. 分类: 分布式系统与并行计算. 版权. 结合AD-PSGD算法,浅谈深度学习并行训练中的 PSGD Manual d’integració Juny 2016 Versió 5.5 Pàgina 3 Des de el punt de vista tècnic, la PSGD oferirà de forma centralitzada un catàleg de serveis a totes les aplicacions de la Generalitat que vulguin disposar d’ells, i convertint-se alhora en un repositori únic i segur per a totes les aplicacions de la Generalitat.Plataforma de Serveis de Gestió Documental

查看更多

Can Decentralized Algorithms Outperform Centralized Algorithms

This is because D-PSGD has comparable total computational complexities to C-PSGD but requires much less communication cost on the busiest node. We further conduct an empirical study to validate our theoretical analysis across multiple frameworks (CNTK and Torch), different network configurations, and computation platforms up to 112 GPUs.模型量化进展长文综述(六)-训练过程. 这篇我们主要介绍一些关于模型量化的训练上的一些创新论文,其实这篇主要是针对QAT的方向,基本的QAT训练流程无非是利用STE(STRAIGHT-THROUGH ESTIMATOR)模拟梯度不可导的地方(round和clip都是不可导的),这篇文章中除了模型量化进展长文综述(六)-训练过程

查看更多

Abstract arXiv:2002.01119v1 [cs.LG] 4 Feb 2020

SGD (AD-PSGD) [2] have been applied to a broad variety of deep learning tasks. Compared to S-PSGD, (A)D-PSGD replaces global weight synchronization with model averaging among neighboring learners in a peer-to-peer fashion while achieving the same convergence rate. In [3], AD-PSGD was first applied to automatic speech recognition 本次演讲中,骆沁毅带来了她和同事们发表在ASPLOS 2020上的最新作品——Prague [1]。. 这是一种在异构平台上进行高效机器学习分布式训练的方法,其特点是融合了目前的主流分布式训练算法All-Reduce和前沿算法AD-PSGD的优点,既能在同质环境下获得高性能,又具有美国南加州大学骆沁毅:构建高性能的异构分布式

查看更多

随机梯度下降(stochastic gradient descent,SGD)

随机梯度下降:. 在每次更新时用1个样本,可以看到多了随机两个字,随机也就是说我们用样本中的一个例子来近似我所有的样本,来调整 θ ,因而随机梯度下降是会带来一定的问题,因为计算得到的并不是准确的一个梯度, 对于最优化问题,凸问题, 虽然不研究者在这篇论文中提出了一种异步去中心化并行随机梯度下降(ad-psgd),能在异构环境中表现稳健且通信效率高并能维持最佳的收敛速率。 理论分析表明 AD-PSGD 能以和 SGD 一样的最优速度收敛,并且能随工作器的数量线性提速。ICML 2018 腾讯AI Lab详解16篇入选论文

查看更多

Can Decentralized Algorithms Outperform Centralized Algorithms

PSGD algorithm and provide the first theoretical analysis that indicates a regime in which decentralized algorithms might outperform centralized algorithms for distributed stochastic gradient descent. This is because D-PSGD has comparable total computational complexities to C-PSGD but requires much less communication cost on the busiest node.PSGD algorithm and provide the first theoretical analysis that indicates a regime in which decentralized algorithms might outperform centralized algorithms for distributed stochastic gradient descent. This is because D-PSGD has comparable total computational complexities to C-PSGD but requires much less communication cost on the busiest node.Can Decentralized Algorithms Outperform Centralized Algorithms

查看更多

PyTorch分布式训练简明教程(2022更新版)

PyTorch是非常流行的深度学习框架,它在主流框架中对于灵活性和易用性的平衡最好。. Pytorch有两种方法可以在多个GPU上切分模型和数据: nn.DataParallel 和 nn.distributedataparallel 。. DataParallel 更易于使 Algorithm 1 Decentralized Parallel Stochastic Gradient Descent (D-PSGD) on the ith node Require: initial point x0,i = x0, step length g,weight matrix W,and number of iterations K 1: for k = 0,1,2,..., K 1 do 2: Randomly sample xk,i from local data of the i-th node 3: Compute a local stochastic gradient based on xk,i and current optimization variable k,i: r Fi(k,i; k,i)k arXiv:1705.09056v5 [math.OC] 11 Sep 2017

查看更多

EAPC Wiki Unitat 2. L’expedient administratiu digital

2.4.1.1 La digitalització a les oficines d’atenció ciutadana. En la unitat 1 es determina la funció essencial de les oficines d’atenció ciutadana respecte a garantir que l’expedient administratiu tingui format electrònic des de l'inici, que és la digitalització dels documents en format paper que les persones interessades aporten en如果直接按照ad-psgd算法来实现原子性操作,在分布式系统中性能会受到很大影响,具体表现在两个方面:原子性操作会导致大量同步成本。 如图13(a)中的实验结果所示,在整个训练过程中,AD-PSGD在不同的数据集上训练的同步开销都比Ring All-Reduce要大。南加州大学钱学海:去中心化分布式训练系统的最新

查看更多

A Faster Decentralized Algorithm for Nonconvex Minimax Problems

Recently many works were proposed to improve the performance of decentralized training. D-PSGD [18] theoretically justifies the potential advantage of decentralized algorithm. D2 [38] improves the convergence rate to outperform D-PSGD by eliminating the influence of data variance among different workers.我们将深度解析机器学习领域顶会ICML 2018收录的16篇腾讯AI Lab论文。. 7月10日至15日,第 35 届国际机器学习会议(ICML 2018)将在瑞典斯德哥尔摩举行。. ICML是机器学习领域最顶级的学术会议,今年共收到2473篇投递论文,比去年的1676篇提高47.6%,增幅显著。. 最终ICML 2018 腾讯AI Lab详解16篇入选论文-CSDN博客

查看更多

梯度下降法(SGD)原理解析及其改进优化算法

2. 梯度下降法迭代步骤. 梯度下降 的一个直观的解释:. 比如我们在一座大山上的 某处位置 ,由于我们不知道怎么下山,于是决定 走一步算一步 ,也就是在每走到一个位置的时候,求解当前位置的梯度, 沿着梯度的负方向 ,也就是当前最陡峭的位置向下走一La gestió documental dels documents electrònics. Introducció. 3.1 El protocol de gestió de documents electrònics i arxiu de la Generalitat. 3.2 Els grups de treball multidisciplinaris de gestió documental. 3.3 L'arxiu electrònic. 3.4 El sistema general de gestió de la documentació administrativa aplicat als documents electrònics.EAPC Wiki 3. La gestió documental dels documents electrònics

查看更多

百度学术 Can Decentralized Algorithms Outperform Centralized

This is because D-PSGD has comparable total computational complexities to C-PSGD but requires much less communication cost on the busiest node. We further conduct an empirical study to validate our theoretical analysis across multiple frameworks (CNTK and Torch), different network configurations, and computation platforms up to 112 GPUs.In AD-PSGD, workers do not wait for all others and only communicate in a decentralized fashion. AD-PSGD can achieve linear speedup with respect to the number of workers and admit a convergence rate of O(1= p K), where K is the number of updates. This rate is consistent with D-PSGD and cen-tralized parallel SGD. By design, AD-PSGD enables wait-Asynchronous Decentralized Parallel Stochastic Gradient Descent

查看更多

Tensorflow 和PyTorch的区别对比,哪个更好?

第 4 点:. Tensorflow 的社区比 PyTorch 大得多。. 这意味着更容易找到学习 Tensorflow 的资源,也更容易找到问题的解决方案。. 另外,小普还注意到,许多教程和 MOOC 都涵盖了Tensorflow,这是因为与 Tensorflow Package ‘PSGD’ April 25, 2023 Type Package Title Projected Subset Gradient Descent Version 1.0.3 Date Maintainer Anthony Christidis <[email protected]>PSGD: Projected Subset Gradient Descent The Comprehensive R

查看更多

(三) DP-SGD 算法解释 jasonzhangxianrong 博客园

For this reason, it would be much preferable if we could instead insert the DP mechanism during model training, so that the resulting model could be safe for release. This brings us to the DP-SGD algorithm. (There is evidence that even when you only care about accuracy, private training still beats private prediction.实验中的主要工具是投影梯度下降(PGD),因为它是大规模约束优化的标准方法。. 令人惊讶的是,我们的实验表明,至少从一阶方法的角度来看,内部问题毕竟是可以解决的。. 尽管在 x_i + S 内有许多局部最大值分散分布,但它们的损失值往往非常集中。. [论文笔记] Projected Gradient Descent (PGD)

查看更多

k arXiv:1705.09056v5 [math.OC] 11 Sep 2017 GitHub

Algorithm 1 Decentralized Parallel Stochastic Gradient Descent (D-PSGD) on the ith node Require: initial point x0,i = x0, step length g,weight matrix W,and number of iterations K 1: for k = 0,1,2,..., K 1 do 2: Randomly sample xk,i from local data of the i-th node 3: Compute a local stochastic gradient based on xk,i and current optimization variable k,i: r Fi(k,i; k,i)本次大会共有6篇论文获奖,其中包括1篇杰出论文奖,4篇杰出论文提名奖,以及1篇时间检验奖。. 来自多伦多大学和谷歌大脑的研究人员斩获杰出论文奖,Hinton高徒郑宇怀获时间检验奖。. ICML 2021是第38届年会,受疫情影响,本届会议在7月18日-7月24日采用线上ICML 2021 大奖出炉!谷歌大脑摘桂冠,Hinton高徒获时间

查看更多

无锡诚丰源贸易有限公司

无锡诚丰源机电有限公司成立于2011年,是一家定向服务于:布鲁克纳拉膜生产线和多尼尔拉膜生产线及康甫分切机各种备品配件的供应商。. 具有一级进货渠道,经过多年的销售,公司已颇具规模的行业先锋,在绍兴,宿迁,无锡都设立了服务公司及拥有自己的PSGD algorithm and provide the first theoretical analysis that indicates a regime in which decentralized algorithms might outperform centralized algorithms for distributed stochastic gradient descent. This is because D-PSGD has comparable total computational complexities to C-PSGD but requires much less communication cost on the busiest node.Can Decentralized Algorithms Outperform Centralized Algorithms?

查看更多- 节能锤式破碎机@生产成本低

- 开破碎石子厂要什么手续

- 矿石的弹性模量

- 陶瓷厂粉煤灰

- 江苏无锡红泥加工生产设备

- 冲击立轴破碎机冲击立轴破碎机冲击立轴破碎机

- 上海5000方碎石机多少钱

- 雷蒙磨宣传设计磨粉机设备

- 鄂破的鄂板价格

- 新型液压圆锥式破碎机

- 内蒙古阿拉善煤渣鄂式破碎设备

- 1小时80方5X制砂机型号

- 寻甸县政府 奕标水泥厂

- 破碎机PF1210

- 液压碎石机的价钱

- 破碎直径在1米以上的大石头机械

- 露天矿成套设备,系列成果

- 岩石破碎拆除设备

- 日产2万吨钠明矾石沙机设备

- 紫砂岩磨粉机械多少钱一台

- 韶铸PE900

- 济宁矿山设备厂破碎机

- 洗沙器原理报价

- 46口径冲击式破碎机

- 成都破碎机销售经理

- 湿碎石一方大概多少顿

- 黎明牌鄂破机

- 商砼欧版磨工作原理

- 石灰石粉厂粉尘浓度

- 上重集团 磨煤机市场